Дипфейки и искусственные изображения — как отличить подделку?

Искусственный интеллект стремительно ворвался в нашу жизнь и стал незаменимым помощником в работе и учёбе. Но вместе с хвалебными одами современным технологиям достаётся изрядная доля критики. И дело даже не в «грядущем восстании машин» и не в жёстко регулируемых вопросах этики. А в использовании технологий ИИ для создания ложной информации и изображений.

Часто в таких действиях нет никакого злого умысла. Пользователи творят и создают, выкладывают результаты работы искусственного интеллекта или фоторедактора в сеть. А дальше людская молва подхватывает фото без контекста и распространяет его как оригинал. В заблуждение вводятся тысячи и миллионы. И мы вновь и вновь сетуем на злокозненные машины, создавшие подделку.

Как не попадаться на дипфейки? На что стоит обращать внимание при анализе фото на подлинность? Какие инструменты можно использовать для оценки реальности изображения? Расскажем обо всём в нашем антидипфейк-гайде.

Изучите подписи к фото

Возможно, вас никто не планировал вводить в заблуждение. И автор честно признаётся — фото сгенерировано искусственным интеллектом и является баловством. Уделив несколько секунд знакомству с подписями к изображению можно предотвратить распространение фейка. И не плодить в сети информацию о появлении «трёхголового оленя».

Браузеры обладают встроенной возможностью поиска по изображению. Это надёжный помощник в выявлении первоисточника фото / Скриншот Azbuka media на основе Google Image

Воспользуйтесь обратным поиском

Каждый крупный поисковик, Google, Яндекс или Bing, а также специальный ресурс TinEye, обладают возможностью обратного поиска по изображению. Загрузите фото, которое вызывает у вас сомнение, и изучите, где оно публиковалось ранее. Если на крупных новостных ресурсах или авторитетных сайтах (например, National Geographic) — скорее всего перед нами подлинник. Ну а если распространяется исключительно в соцсетях, то есть серьёзный повод усомниться в реальности материала.

Приятным бонусом часто является разбор искомой фотографии фактчекерами. Такие анализы снимка вы тоже можете найти через обратный поиск. Возможно, вирусную фотографию уже кто-то изучил и дал по ней компетентное заключение. Как это делали мы с фото «рождественской ели в Израиле, украшенной палестинскими детьми в саванах» (это оказалось фейком).

Часто фейковым является не изображение, а коннотация. В частности, СМИ в январе 2024 заявили, что Израиль установил ель с палестинскими детьми в саванах. Ель оказалась реальной, но её установили в Ираке / Фото Ahmed Jalil, EPA-EFE

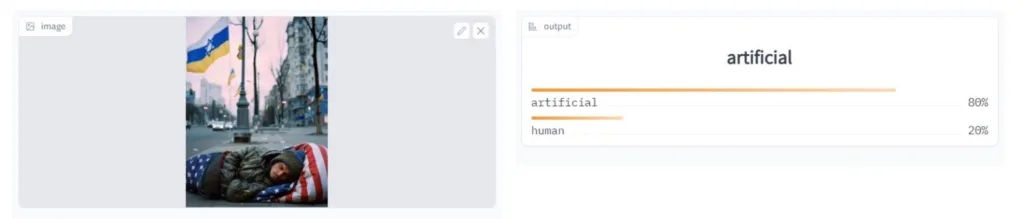

Используйте специальные приложения по определению искусственного интеллекта

Развивается не только искусственный интеллект, но и ресурсы по его идентификации. И то, и другое пока несовершенно. Но полезно иметь помощников в лице специальных сайтов по выявлению работы искусственного интеллекта. Многие из них бесплатные и даже не требуют регистрации. Лучшие сайты по анализу фото на искусственный интеллект — это Huggingface, Illuminarty, Content at Scale, AI Or Not.

Не стоит возлагать на них непосильную ношу безграничного доверия. Даже такое профильное программное обеспечение иногда ошибается. Поэтому оптимальным будет проверить изображение сразу на нескольких сайтах. И если в большинстве случаев вы получили одинаковый вердикт, ему можно в значительной степени доверять.

Проверка фото на искусственный интеллект программой Huggingface простая. По итогу вы получите вердикт и оценку уверенности в нём программы / Скриншот Azbuka media

Присмотритесь к деталям

Как мы уже отметили выше, искусственный интеллект, к счастью или к несчастью, допускает ошибки. Даже идеально составленный промт (запрос на выдачу результата) не означает идеального итога. К самым распространённым ошибкам ИИ на сегодня относятся:

- лишние пальцы рук или размытые конечности,

- чрезмерно глянцевая кожа, зачастую несоответствующая возрасту или социальному статусу изображённого человека,

- незаконченные (непрорисованные) детали изображения — например, украшения, уши или пряди волос,

- разный цвет глаз,

- искривлённые символы, такие как неправильные полосы на флаге, а также неестественный фон,

- неестественные позы людей на снимке,

- несоответствие одежды внешним условиям.

Последний фактор стал убедительным доказательством фейковости фото Илона Маска и Марка Цукерберга в ванне. Даже предположив внезапное потепление отношений двух бизнесменов, невозможно объяснить обернувшиеся вспять законы физики и сухую футболку во время купания.

Одна из серии скандальных фото об Илоне Маске и Марке Цукерберге. Обратите внимание на сухую футболку Маска несмотря на пребывание в воде / Фото пользователя MisdyOfficial на Facebook

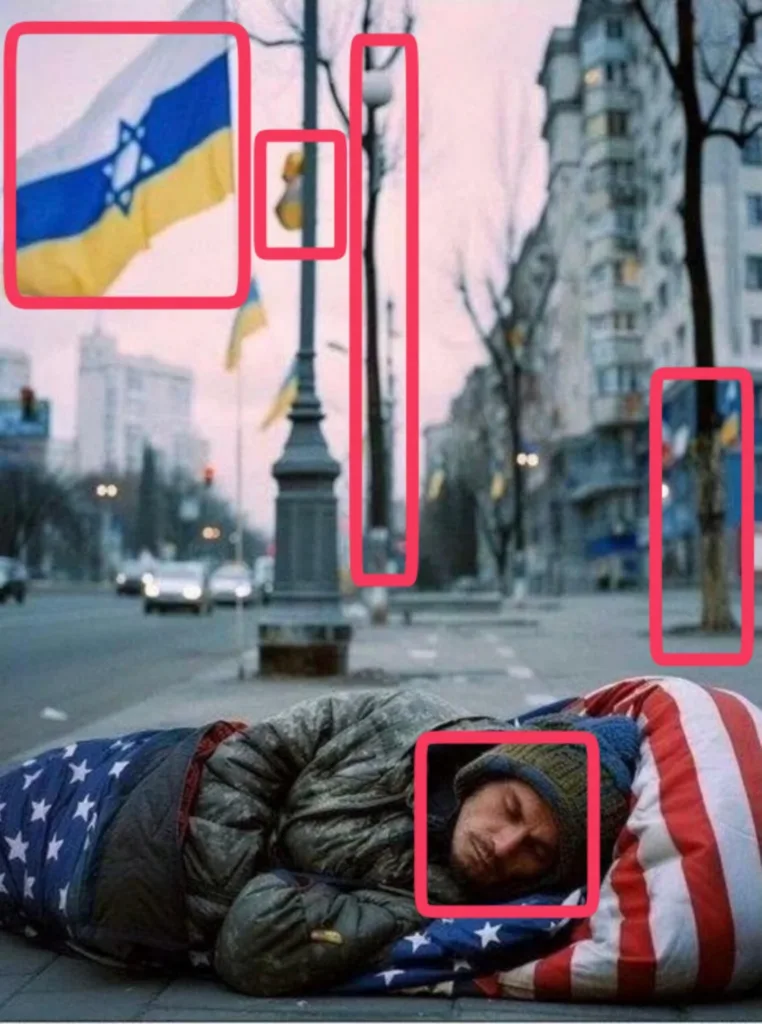

Обратите внимание на фон

Поддельное фото могут выдать не только мелкие детали, но и общий фон изображения. Предмет находится близко от объектива, но почему-то размыт? Скорее всего перед нами результат несовершенной работы ИИ.

Индикатором фейка могут стать серьёзные отличия идентичных объектов. К примеру, расположенные рядом однотипные деревья имеют разный цвет — одно серое, а второе коричневое. Либо же предметы неестественно искривлены. Весь набор таких признаков мы нашли в снимке «нищего на улице американского города», который оказалось подделкой.

Фейковый снимок выдаёт ряд признаков: фонарный столб будто слился с деревом, на другом столбе находятся нераспознаваемые элементы. Дерево справа разноцветное: снизу ствол светлый, а в середине внезапно темнеет / Azbuka media

Задумайтесь над контекстом

Природа дала нам сильный инструмент в противостоянии дезинформации — эвристику доступности.

Эвристика доступности — это интуитивный процесс, в ходе которого человек оценивает каждое событие или явление как более или менее вероятное на основании жизненного опыта. Для этого нет нужды задумываться, наш мозг принимает решение мгновенно. Если нам сказать, что «на Марсе найдена вода», велика вероятность, что мы поверим — ведь о воде в прошлом на красной планете говорили давно, причём авторитетные издания. Но если сказать, что «на Марсе найдена высокоразвитая цивилизация» — скепсис наш будет запредельным. Именно эвристика доступности даёт красный свет тому, что не соответствует нашему жизненному опыту и знаниям.

При должной тренировке природного механизма эвристики доступности она преобразовывается в важнейший навык, критическое мышление. Наше сознание незаметно, но действенно верифицирует любое утверждение, попадающее в него. Пользуйтесь им, чтобы отличить подделки от реальных фото.

Критическое мышление, например, поможет вам установить, что фото Папы Римского Франциска в шикарном пуховике — фейк. Верховный понтифик известен своей скромностью и смирением. И уж тем более он не станет покупать эти самые пуховики в магазине, напоминающем вещевой рынок в Москве.

Папа Римский Франциск в дорогом пуховике. Необязательно обладать техническими знаниями, чтобы понять — перед нами фейк / Azbuka media

Обратитесь к автору фотографии

Этот совет пригодится профессиональным журналистам и фактчекерам, которые хотят убедиться в подлинности изображения «из первых уст». Часто под фотографией содержатся данные её создателя. К нему-то и можно обратиться напрямую и уточнить, действительно ли перед нами настоящий снимок, или автор просто шутил?

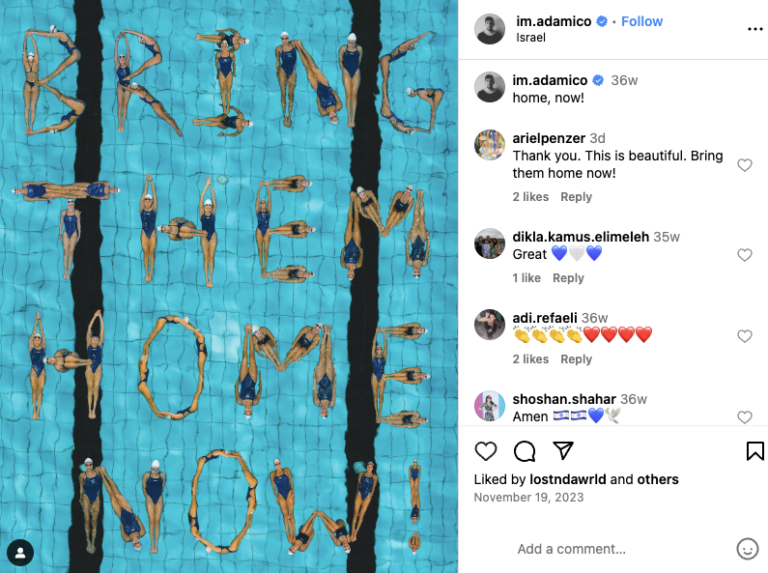

Подобный способ оказался действенным в случае с фото израильских спортсменов, выложивших в бассейне своими телами надпись «Bring Them Home Now». Она означала требование вернуть заложников, захваченных боевиками ХАМАС в октябре 2023 года. Пользователи утверждали: подобную композицию спортсмены выложили на Олимпиаде в Париже. Однако это не так: специалисты Reuters Fact Check связались с автором снимка, Адамом Шпигелем, и выяснили — фотоколлаж действительно был, но его сделали за год до игр, 17 ноября, в Израиле.

Фотоколлаж подлинный, но коннотация не верна. Снимок сделали не на Олимпиаде, а в Израиле, ещё 19 ноября 2023 / Фото Adam Spiegel

Искусственный интеллект — не единственный автор фотоподделок. Технологии давно позволяют обычному пользователю с базовым приложением на компьютере сделать реалистичное изображение. Несколько кликов мышкой, пять минут в фоторедакторе иногда оборачиваются часами анализа на достоверность и обманом миллионов людей. Однако на пути фейков может стать каждый из нас, использующий базовые правила проверки изображений на подлинность:

- использование обратного поиска по изображению,

- анализ фото доступными программами — Huggingface, Illuminarty, Content at Scale, AI Or Not,

- внимательное изучение фона на предмет искривлённых линий, размытости и несоответствий,

- изучение деталей снимка, особенно конечностей и кожи людей,

- и обязательно скепсис как основа критического мышления!

@bajmedia

@bajmedia